プレスリリースBACK NUMBER

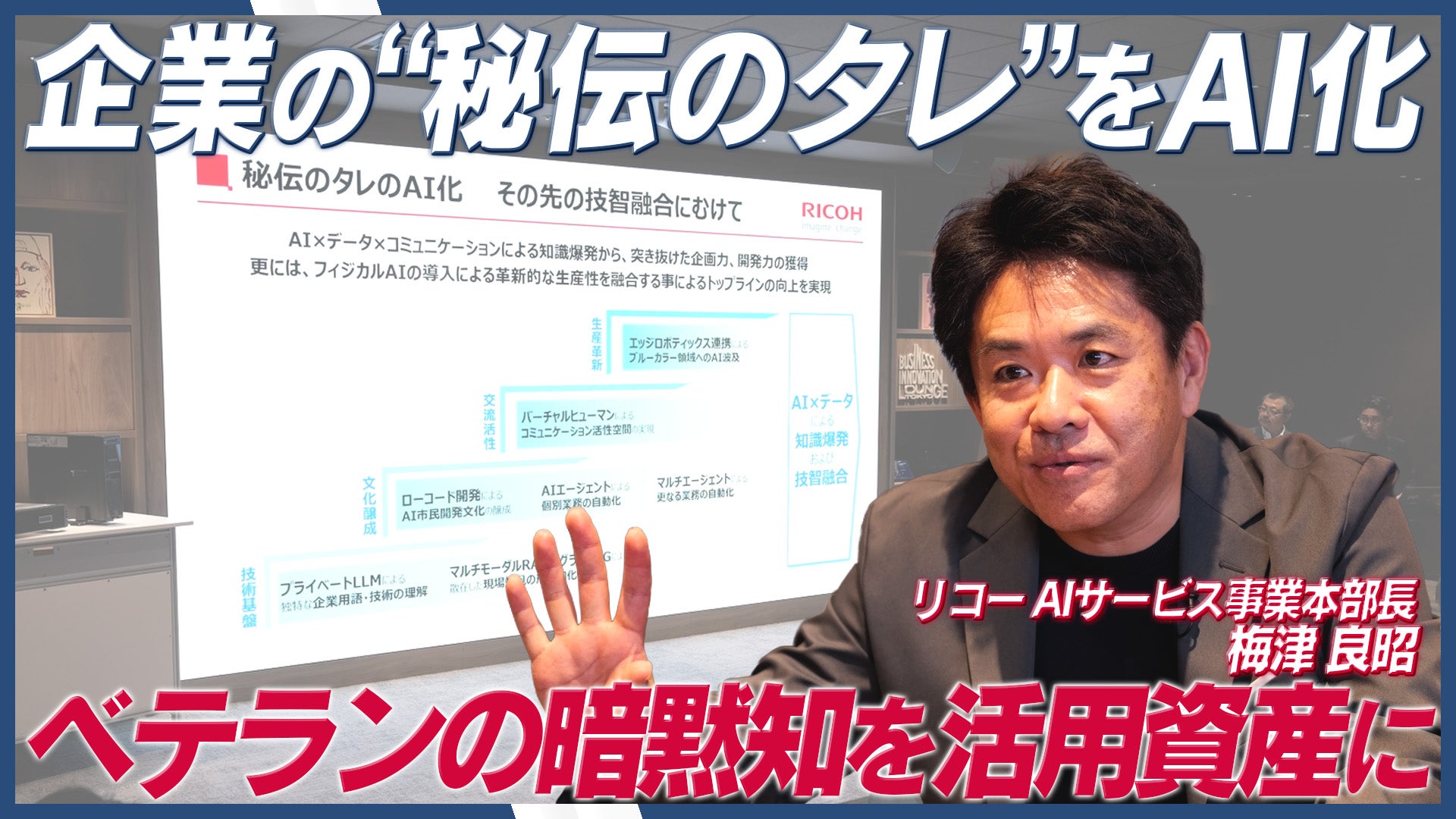

リコー、企業の“秘伝のタレ”をAI化 暗黙知を形式知にする秘伝のタレ プラットフォーム構想を発表

posted2025/12/10 16:00

株式会社リコー(社長執行役員:大山 晃)は、企業内に眠る「暗黙知」や「非構造化データ」を資産に変え、競争力の源泉となる「秘伝のタレ」へと昇華させるためのAI技術基盤「秘伝のタレ プラットフォーム」、およびオンプレミス環境への導入に最適な最新の日本語大規模言語モデル(LLM※1)の開発成果を発表しました。

■背景:失われゆく知見と活用されないデータの課題

現在、国内人口の約3割が65歳以上(※2)となり、熟練技術者(ベテラン)が持つ貴重な暗黙知が継承されずに喪失するリスクが高まっています。また、企業が保有するデータの約70%〜90%は、図表や文書などの「非構造化データ」が占めている(※3)と言われており、これらが十分に活用されていないという課題に対し、リコーはデジタルの力でこれらの「見える化」を目指します。

■「秘伝のタレ」を作る技術基盤リコーは、企業独自の用語や技術を理解するプライベートLLMと、高度なRAG技術を組み合わせた「マルチエージェンティックRAG」環境を構築します。「司令塔」となるAIエージェントがユーザーのリクエストを自律的に解釈し、専門エージェントと連携。図表を読解する「マルチモーダルRAG」や、文書間の関係性を紐解く「グラフRAG」、表計算データを扱う「Text2SQL」といった各種RAGを統制し、散在した現場の知見を統合・形式知化し、AIと人が共に働く「技智融合」による生産性革新を推進します。

■新開発:オンプレミスに最適な「Gemma 3」ベースの高性能LLM

本構想を支える技術として、Googleが提供するオープンモデル「Gemma 3 27B(※4)」をベースとした新たな日本語LLMを開発しました。リコー独自のモデルマージ(※5)技術を活用し、独自開発を含む約1万5千件のデータから指示追従能力のみを抽出したChat Vector(※6)などを作成・マージしています。これにより、270億パラメータというコンパクトなサイズでありながら、米OpenAIの「gpt-oss-20b(※7)」をはじめとする最先端モデルと同等の性能を確認しています。

本モデルは、ユーザー体験を重視した非推論モデル(※8)ならではの高い初期応答性(※9)と執筆能力を兼ね備えており、PCサーバ(※10)等での構築が可能です。セキュリティを重視する企業においても、低コストかつ環境負荷を抑えたプライベートLLMの導入を実現します。

■今後の展開

本LLMは、エフサステクノロジーズ株式会社の対話型生成AI基盤「Private AI Platform on PRIMERGY」に搭載され、ノーコード開発プラットフォーム「Dify」と組み合わせて2025年12月下旬より提供されます。リコーは今後、推論性能(※11)の強化や業種特化モデルの開発を進め、お客様のDXを支援してまいります。

※1 Large Language Model (大規模言語モデル): 人間が話したり書いたりする言葉(自然言語)に存在する曖昧性やゆらぎを、文章の中で離れた単語間の関係までを把握し「文脈」を考慮した処理を可能にしているのが特徴。「自然文の質問への回答」や「文書の要約」といった処理を人間並みの精度で実行でき、学習も容易にできる技術。

※2 出典: 厚生労働省「我が国の人口について」 https://www.mhlw.go.jp/stf/newpage_21481.html

※3 出典: Gartner®, "AI-Readyデータに備えるCIO向けガイド" (2025年4月7日) - ID G00828698 By: Tatsuya Ichishi. GARTNERは、Gartner Inc.または関連会社の米国およびその他の国における商標または登録商標です。

※4 https://ai.google.dev/gemma/docs/core?hl=ja

※5 モデルマージ: 複数の学習済みのLLMモデルを組み合わせて、より性能の高いモデルを作る新たな手法。GPUのような大規模な計算リソースが不要で、より手軽にモデル開発ができるとして、近年注目されています。

※6 Chat Vector: 指示追従能力を持つモデルからベースモデルのウェイトを差し引き、指示追従能力のみを抽出したベクトル。

※7 https://openai.com/ja-JP/index/introducing-gpt-oss/

※8 非推論モデル: 学習済み知識から直接回答を生成する思考プロセスを持つモデル。推論のステップを省略するため、明確な指示を与えれば、迅速に回答生成が可能。

※9 初期応答性 (Time to First Token: TTFT): ユーザーがAIにプロンプト(質問や指示)を入力してから、モデルが最初の出力テキスト(トークン)を生成し始めるまでにかかる時間を測定する応答速度の指標。ユーザー体験(UX)に直接影響する。

※10 PCサーバ: 一般的なパソコン製品と共通の技術や仕様、部品などを用いて設計、製造されたサーバコンピュータ。専用サーバに比べて、一般的には安価に導入が可能。

※11 推論性能: LLMが単に情報を検索したりテキストを生成したりするだけでなく、複数のステップからなる論理的な思考プロセスを経て結論を導き出す性能。

株式会社リコー:https://jp.ricoh.com/

動画プレスリリース・動画ニュースリリース詳細へPR TIMES TVトップへ